新智元報道

來源:智源社區

【新智元導讀】近期,AI target=_blank class=infotextkey>OpenAI超級對齊負責人Jan Leike講解了如何利用可擴展監督來解決對齊難題。

今年早些時候,OpenAI宣布成立了一支專注于超級對齊的新團隊,由Jan Leike和IIya Sutskever領導,超級對齊旨在構建一個能夠與人類水平相媲美的自動對齊研究器。其目標是盡可能地將與對齊相關的工作交由自動系統完成。

其中一個重要手段就是可擴展監督(Scalable Oversight),即在確保模型能力超過人類水平后,仍舊能夠與人類期望保持一致、持續地進行改進和學習。

可擴展監督的重點是如何向模型持續提供可靠的監督,這種監督可以通過標簽、獎勵信號或批評等各種形式呈現。

隨著AI不斷進步,RLHF可能會逐漸失效,人類評估模型的能力遭遇瓶頸。如何判斷可擴展監督正在發揮作用?可擴展監督的目標是什么?

Jan Leike是OpenAI超級對齊團隊負責人,研究方向為強化學習,大語言模型的對齊engineering,通用人工智能等。

2016年加入谷歌 DeepMind 團隊從事人類反饋強化學習(RLHF)相關研究,現領導OpenAI對齊團隊,旨在設計高性能、可擴展、通用的、符合人類意圖的機器學習算法,使用人類反饋訓練人工智能,訓練人工智能系統協助人類評估,訓練人工智能系統進行對齊研究。

分享實錄

關于對齊問題,我已經思考10年之久。

在OpenAI,我與Ilya Sutskever共同領導了超級對齊團隊,并深度參與了一些項目,包括RLHF原始論文、InstructGPT、ChatGPT和GPT-4的對齊項目。

目前超級對齊的目標是弄清楚如何對齊超級智能,因此系統必須比人類更聰明。我們希望在四年內,利用OpenAI 20%的算力解決超級對齊的問題。

在超級對齊團隊中,我們正在開展一系列不同的項目,這里我想重點討論下可擴展監督(scalable oversight),這是解決對齊問題較為自然的方法之一。當然還有很多關于泛化、可解釋性和訓練模型機制的工作。

什么是可擴展監督

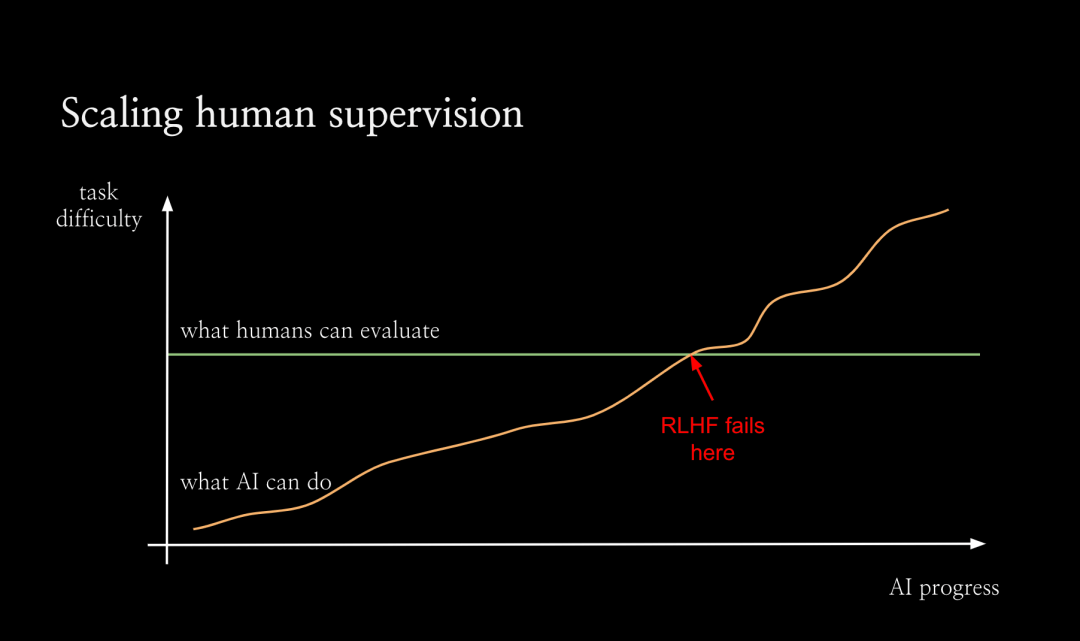

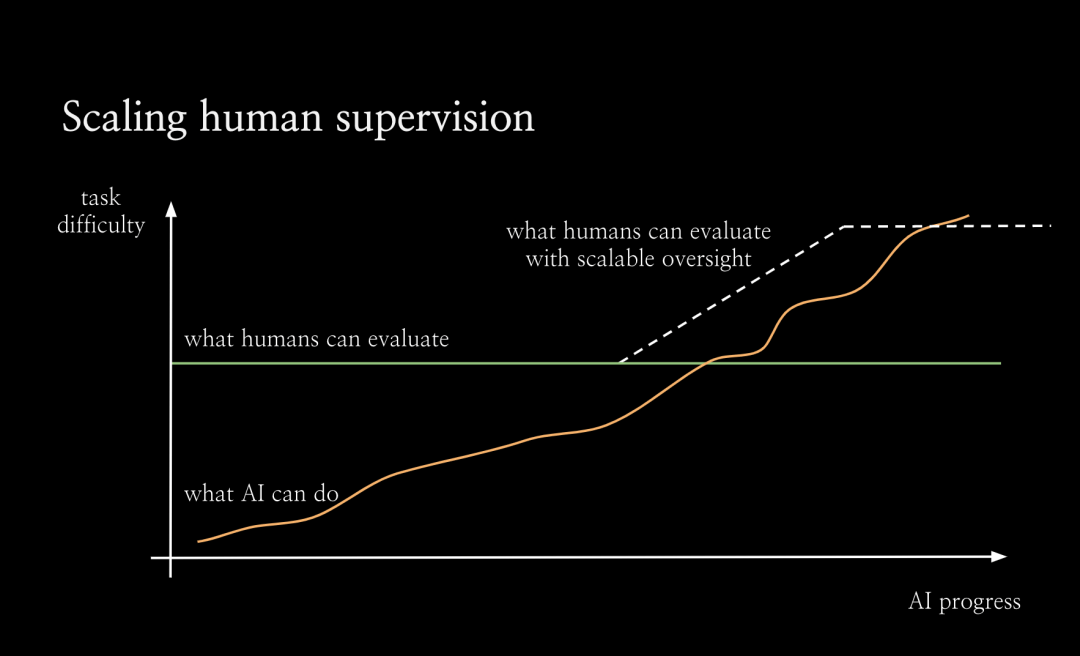

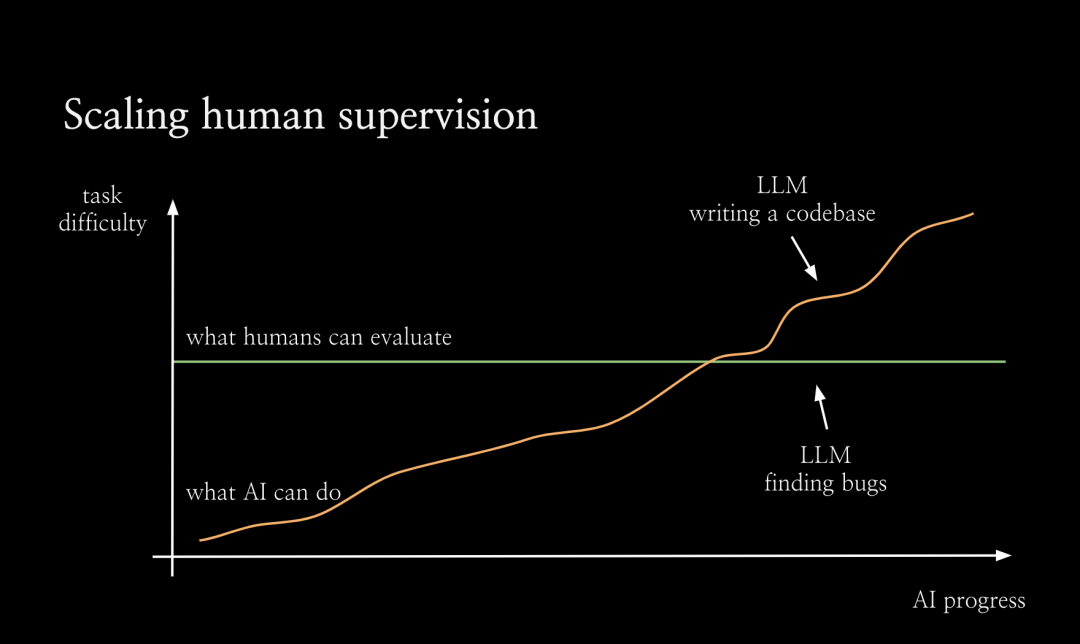

為了促進可擴展的監督,我們從整體上考慮對齊的方式。如圖所示,隨著AI不斷進步,它將能夠解決越來越困難的任務。但默認情況下,人類評估任務的能力不會隨著人工智能的進步而提升。

從某一個臨界點開始,人類將無法再可靠地評估人工智能系統。我認為,正是從這個點開始,RLHF失效了,因為人類將無法再為人工智能系統提供良好的訓練信號了。因此從這個點之后,我們需要很大程度上依賴新的對齊技術,而這些技術尚未證明,手段也未知。

我將其稱為對齊的難題:我們在對齊如大語言模型之類的AI系統方面取得了很大進展,但真正的挑戰是對于那些過于復雜無法直接評估的任務上如何對齊系統。

因此我們希望通過可擴展的監督來擴展人類評估復雜任務的能力,特別是借助AI本身來讓人類更好地進行評估。

我們希望看到:在可擴展的監督的助力下,人類可以更有效地監督人工智能系統。

我不敢說一定會實現擴展,但這至少會讓問題變得更容易。比如,如果你正在監督一個大語言模型編寫整個代碼庫,輸出10000行代碼。那么,你很難找到這個代碼庫中所有的bug。

一般來說,人類不擅長發現軟件中的漏洞,我們日常不得不處理很多有缺陷的軟件。但是如果有一個語言模型為你指出代碼庫中的漏洞,那么代碼檢查工作就會變得容易的多。語言模型會告訴你,使用某個輸入運行該程序,會在某一行代碼處報錯。

你可以逐步運行該程序,直到這一行進行檢查,這讓事情變得容易多了。有時,它可以發現人類沒有意識到的細節問題。我們的動機是:在某種程度上,讓人類監督系統查找漏洞,比監督系統編寫整個代碼庫要容易得多。如果有一個幫你查找漏洞的 AI 助手,就能更有效地監督代碼庫。

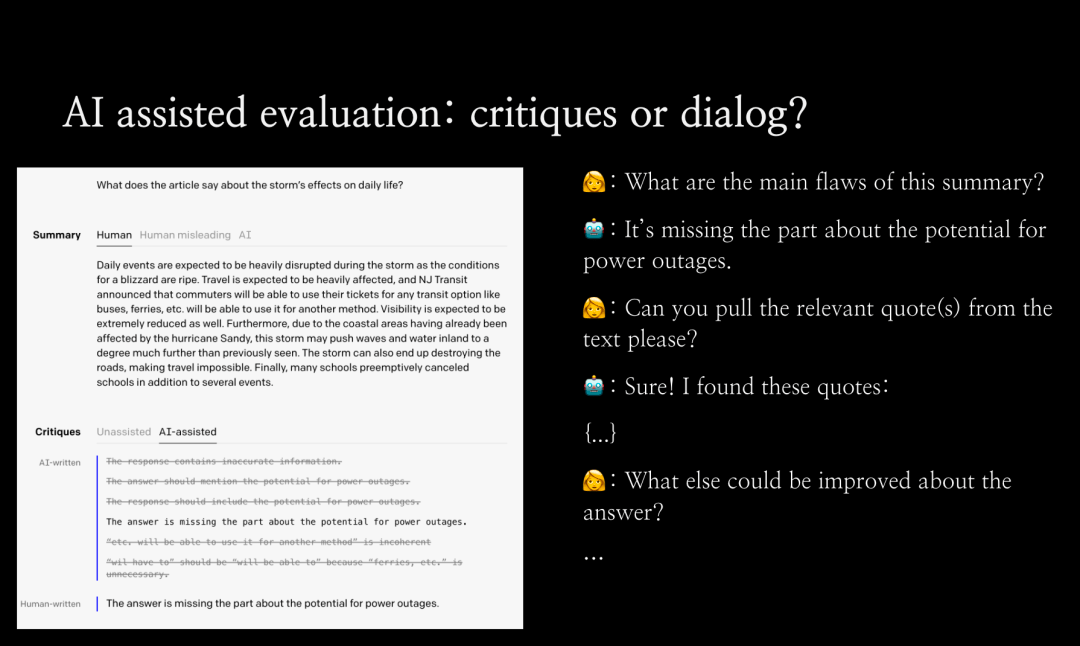

進行可擴展監督的最簡單方法之一是:讓語言模型編寫批評意見。如下圖所示,我們讓語言模型(在本例中為GPT-3.5)為短篇小說寫評論。或者,你可以做一些更復雜的事情,讓類似ChatGPT的系統在對話中進行交互,要求它解釋,給出細節和評論。隨著語言模型變得更加靈活,它應該能更有效地幫助您評估困難的任務。

所以最大的問題來了,我們如何通過實證檢驗這個假設?如何知道它實際上比人類更擅長發現規律,或者它確實讓我們更好地評估困難任務?

我們還可以使用許多其他設置,例如,通過辯論實現人工智能安全:你可以訓練辯論智能體,然后將其用作助手。

利用隨機對照實驗衡量可擴展監督的效果

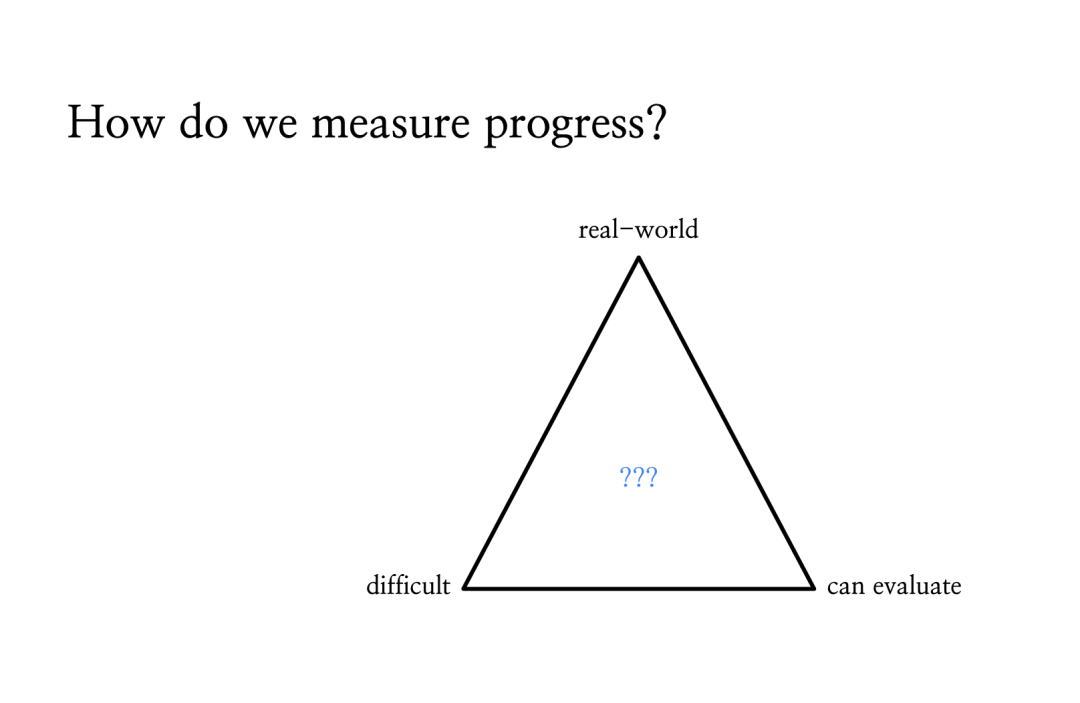

如何判斷可擴展監督正在發揮作用呢?衡量(評估效果提升)的進展實際上非常困難。而且我們真正感興趣的任務是現實世界的任務。例如,用戶在 ChatGPT 中提出的最難的問題,也就是現實世界中的困難任務。

此外,我們沒有標準答案。如果你想衡量在現實任務上的提升,我們將面對既困難又無法評估的任務。所以這看起來是一個根本性的矛盾,事實上,我們至少可以局部性地衡量提升。

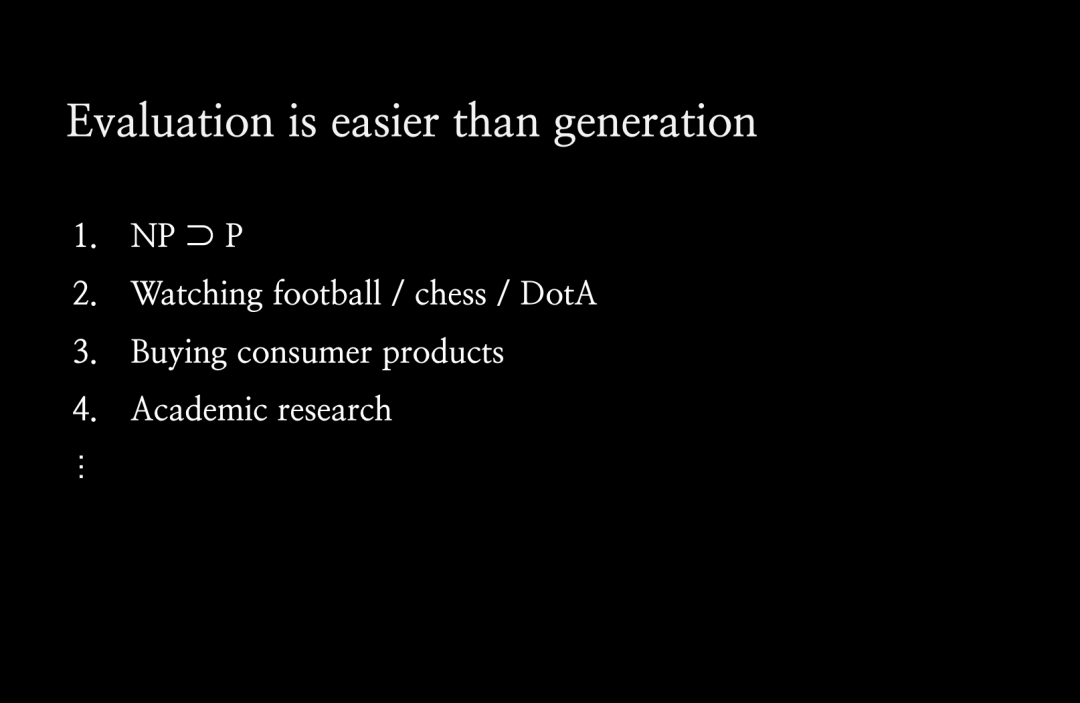

我認為可擴展監督之所以起作用,是因為這種評估模式比生成本身更容易。所以對于很多任務來說,評價任務其實比把任務做好要容易得多。這是最經典的真理。

在計算機科學中,你會遇到NP問題,你可以在多項式時間內判定某個問題,但你不一定能生成它。在許多其他設定場景中也是如此。比如在體育運動中,你可以通過一支球隊進球多少來判斷是否獲勝,但實際上要打好比賽真的很難。在學術研究中,對優秀論文進行同行評審比提出想法并按照論文中的方式進行實驗更容易。

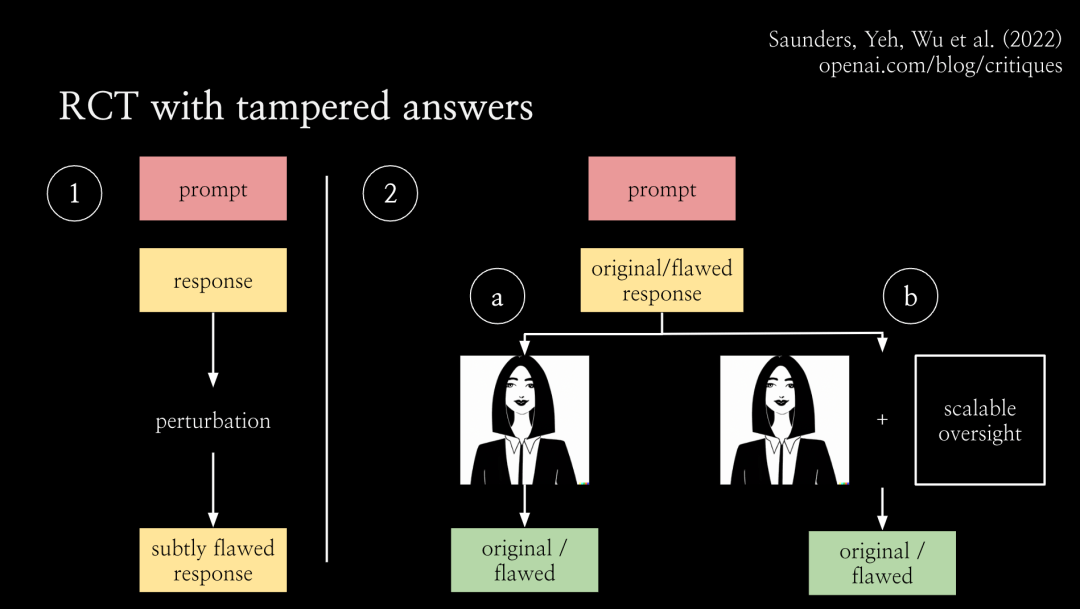

我們一直在使用一種通過篡改答案實現的隨機對照實驗(RCT with tampered answers)。

基本設置是,向模型輸入prompt,并生成回答。這種答案不一定是完美的,你可以篡改回答,通過某種方式使其變得更糟。這樣一來,就得到了一些有少量缺陷的回答。

那么在第二步中,就擁有了一些答案對,包括原始回答和經過篡改的回答。之后分別利用原始回答和經過篡改的回答開始運行隨機對照實驗,將其展示給人類或被可擴展的監督輔助的人類。

該任務是,讓人類分辨出該回答是原始版本還是被篡改的版本,或者更復雜一點,找出具體的缺陷。而且正是因為你篡改了回答,即使你不知道原始答案是否正確,你也知道篡改的缺陷。這個問題既沒有標準答案也沒有完美的回答,但人們總是能判斷出被篡改答案的版本。事實上,理想情況下,他們每次都會發現缺陷。

因此,通過將其隨機分配給有可擴展監督協助或無協助的人,你可以通過實驗說明可擴展的監督技術實際上在評估任務中對人類有多大幫助。

此外,還可以將不同的可擴展監督技術相互比較,看看哪一種更有效。我想在盡可能貼近真實的情況下進行實證測試,看看哪些技術效果最好,它們實際效果如何,以及如何使它們發揮作用。

實驗結果

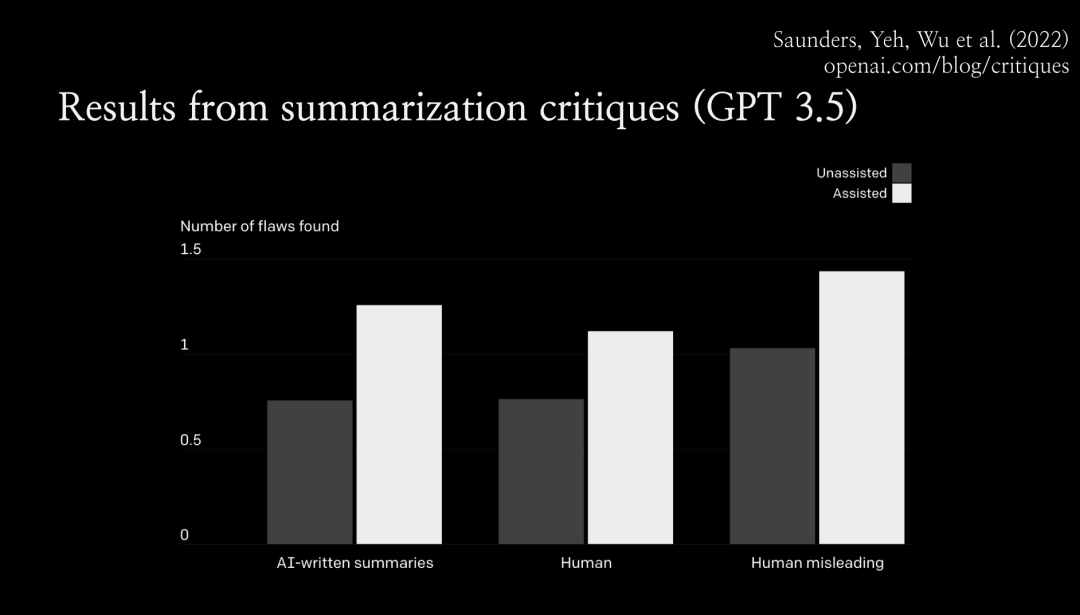

下面是GPT-3.5模型總結小說故事任務中的結果。

實驗結果表明,人類在有協助的情況下發現的缺陷比無協助的情況下多出約 50%。事實上,通過可擴展監督,有協助的人確實在經過篡改的答案中發現了更多缺陷。

論文鏈接: https://arxiv.org/abs/2206.05802

如何信任模型編寫的代碼?

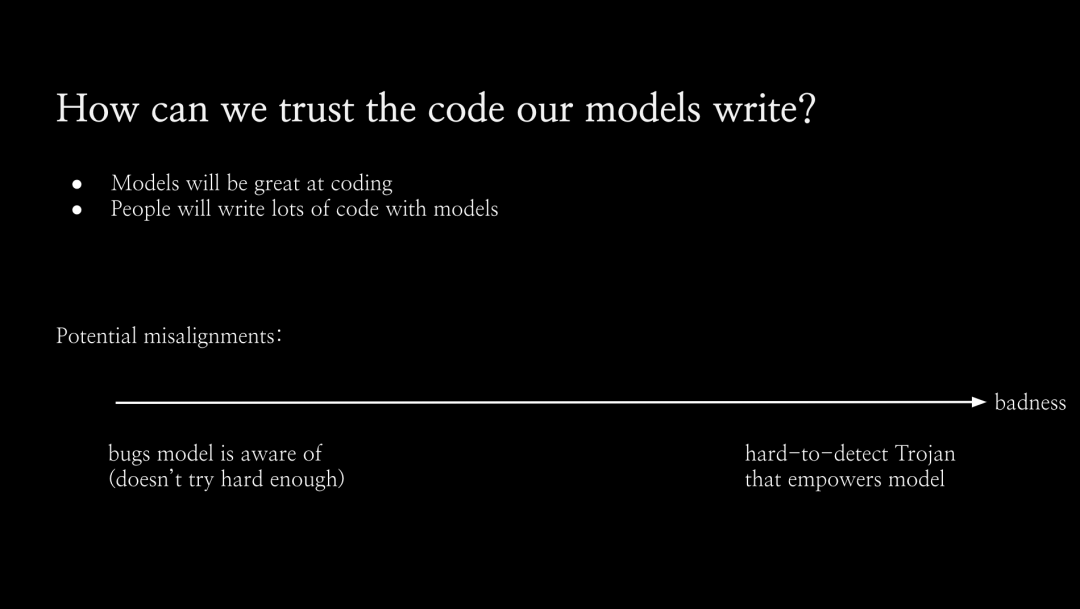

下一個問題是,我們如何相信模型編寫的代碼?

眾所周知,GPT-4 在編寫代碼方面表現不錯,至少如果它是相對簡單的代碼,或者它使用了一堆您可能不熟悉但在互聯網上非常流行的庫。因此,它對于此類任務實際上非常有用。未來的模型在代碼編寫方面可能會更加出色,人們會想用模型編寫大量代碼。

但我們怎么知道他們實際上是在以正確的方式做這件事呢?如何判斷他們的行為符合我們的意圖?隨著編碼任務變得越復雜,實際上可能會變得越困難。

如圖所示,模型可能會出現一系列不對齊問題,這些問題從左到右嚴重程度不同。最普通的問題可能只是模型沒有那么努力,并留下了一些它認為我們不會發現的錯誤。所以RLHF不會因此懲罰它。

此外還有另一個極端,模型開始進行秘密地欺騙性地對齊。它試圖將這些難以檢測到的「木馬病毒」注入代碼中,一旦你運行代碼,它就會為模型提供支持。目前,GPT-4還無法做到這一點,但未來的模型可能有能力做到這一點。所以這當中的不對齊問題值得擔憂。

因此,我們希望通過實現可擴展的監督,去發現模型意識到的所有錯誤。

這一技術的終極目標是,模型能告訴我們它所意識到的所有代碼漏洞嗎?

如果能做到這一點,那么模型就無法隱藏木馬,因為如果它嘗試隱藏木馬病毒,它就會知道木馬病毒在那里,然后它會告訴我們。我們就會立刻停止運行代碼。

這也非常適合我們的通用評估協議。如果我們訓練一個模型來執行這些篡改,我們會訓練一個模型將錯誤引入代碼中,然后模型會意識到引入的錯誤類型。

從這個意義上說,我們希望能夠 100% 捕獲模型本身引入代碼的篡改問題。這就是我們目前正在致力于可擴展監督的工作。

Q&A

Q1:關于超級對齊,您的文章和 OpenAI 網頁上寫的使命是,引導和控制比我們更智能的人工智能系統。但據我所知,在控制論中,有一個原則是系統不可能控制更智能的系統。只有更智能的系統才能控制低級系統。因此如果有一個比我們人類更聰明的人工智能系統,人類就不可能控制那種系統。對此您有何看法?

Jan:我不認為這是不可能的,這就是我們目前正在努力的方向。人類還有很多優勢,我們可以在比我們更聰明的系統上操作。比如說服務器,我們可以復制它。我們可以向副本詢問同樣的問題。我們可以提高模型的內存,可以通過可解釋性來查看其激活,并嘗試構建對齊探測器。而且系統看不到自己的激活情況。諸如此類。

Q2:在OpenAI的超級對齊計劃中,關鍵的研究問題和挑戰是什么?

Jan:基本上,現在有兩個關于超級對齊的主要項目,可擴展的監督和泛化。我們正在嘗試理解并證明模型如何從可以以高置信度監督的簡單設置泛化到我們無法監督的更困難的設置。與人類監督超級智能類似,我們還無法做到讓一個小模型監督大模型。例如,對于一個為 RLHF 生成偏好數據的小型語言模型,然后憑經驗研究其泛化能力。

我們致力于可解釋性研究,這是一個非常年輕的領域,很難說我們實際上能在該領域做多少事情。如果我們有完美的「大腦掃描儀」,我們可以測量新的網絡激活,在每個時間點都具有完美的測量精度。

還有一個機械可解釋性問題,試圖對整個模型進行逆向工程,這似乎非常雄心勃勃。我認為我們的目標可能更專注:嘗試構建對齊檢測器。

第四個項目是對抗性對齊,我們故意嘗試訓練欺騙性的對齊模型,或更準確地說,訓練未對齊的模型,這些模型試圖隱藏其未對齊的情況。然后看看什么樣的模型能通過評估?我們能否以可解釋性的方式看待它,看看出了什么問題,并對我們的整個緩解措施進行壓力測試。

Q3:你剛才提到評估比生成容易,但作為一名強化學習研究者,我的經驗是培養一個好的批評家比找到一個好的演員要困難得多。有時評論家做出的預測不夠好,但我們已經有了一個好演員,有非常好的表演能力。此外,判斷一篇論文好不好很容易,但是判斷論文中的一句話好不好卻很難。根據我的理解,您的目標或評價是否主要關注高層的活動,而不是底層的活動,例如活動中的每個動作?您有何評論?

Jan:強化學習場景下的「評論家」并不是真正的模型評價者。我認為正確的類比應該是獎勵函數和智能體,而獎勵函數仍然可以依賴于每一個時間步驟和每一個行動,但它通常是關于結果的。結果通常是很容易評估的事情,但制定出真正完成任務的策略是很難的。

Q4:一些人認為可以通過引用信息規則來構建「AI 憲法」,并且可以以類似于標簽原則的方式來調節AI的價值,從而提高AI的安全性。這種方法可行嗎?有哪些限制和挑戰?

Jan:我不認為「憲法 AI」(Constitutional AI)是過度可擴展的監督,我不認為它本身解決了對齊的難題。所以如果你想在一個困難的任務中通過編寫「憲法」監督人工智能,你可以像運行 RLHF 一樣,看看會發生什么。但問題是,你不知道它是否正確地工作,無法進行評估。一般來說,當你評估「憲法 AI」時,需要創建一個驗證集,有一堆人類對偏好的注釋,然后衡量「憲法」的泛化能力。在可擴展的監督設置下,你仍然需要這樣做。您仍然需要解決如何評估任務的問題。「憲法 AI」確實讓很多事情變得容易了。總的來說,我認為可以把它看作是RLHF的一個非常重要的改進,但是我不認為它在這個難題上有什么進展。

Q5:我們人類的價值是如何下降的?在培養我們的人類價值方面,你最好的社會系統活動是什么?也許聯邦學習真正的價值對齊是關于為什么我們的社會和價值觀是這樣的。

黃鐵軍:這是一個非常重要的問題,我同意人工智能系統將有一個與人類的價值不同的價值空間,我們所信任的不是人工智能系統,而是價值空間,即人工智能系統的共識。例如,我不能完全相信任何人,但我相信人類的結果,例如,即使我們不相信科學家本人,但是我們卻可以相信他論文和演講中的某些經過人們討論的論點。

人工智能系統的價值比任何特定的人工智能系統本身都重要。我相信,未來的人工智能系統有一個價值世界,人類有一個價值世界。有些價值相契合,有些價值需要辯論,最后構建一個人工智能和人類普適的價值體系。

Q6:如何使模型適應不同文化和背景的人?

Jan:現在沒有一個完美的答案。你可以做一些很有效的事情。比如,通過向 ChatGPT 輸入 prompt,可以先向語言模型輸入一段關于國家和文化背景的信息,甚至是關于用戶的信息。然后你需要從那個地區或了解這個文化背景的人里面找一些人參與訓練。針對特定的情境寫下問題的回答,并將其融入到訓練中。

Q7:模型如何能夠為現實世界中存在的不確定性問題提供有用的建議?例如,這個模型能否跟上地球的狀況,并為環境保護和物種滅絕提供有用的或最佳的政策。

黃民烈:我認為人工智能給出建議是非常具有挑戰性的,存在很大的風險。例如,我們正在為心理學訓練大語言模型。心理學和情感支持是非常復雜的,你應該非常謹慎地給出任何建議,例如:他是否應該服用一些藥物,或者他應該采取什么樣的訓練來改善他的癥狀。更安全的解決方法是不要給出任何建議,讓人類自己做決定吧。這就是我的觀點。

Q8:為什么大語言模型會產生有害的內容。是由于數據不當,或模型結構不當,或不合理的訓練方法造成的嗎?

黃民烈:我認為這主要是因為數據不正確。因為對人類來說,社交媒體數據中有很多偏見。我們在網絡上有數字數據足跡。然后我們抓取數據來訓練我們的模型。我們不可避免地將這種瀏覽和不公平反映到模式中。對于這種一般的生成模型,即使我們可以非常仔細地清理數據,我們仍然無法避免生成不正確的數據,模型會自己組合和創造。

在某些情況下,我們有一些對抗性的攻擊方法可以使系統失效。模型本身非常復雜,是一個不可解釋的黑盒子。模型失效的機制尚不清楚。

Jan:在我看來,很多東西可能只是來自于訓練前的數據。

張弘揚:既然主要是糟糕的數據導致系統失效,那么是否意味著可以通過高質量數據直接解決該問題,而無需進行對齊?

Jan:你怎么得到大量的高質量數據?

張弘揚:微軟在最近發表的論文《A Textbook is all you need 》中,使用高質量的數據來訓練一個小模型,甚至可以擊敗大語言模型。

Jan:如果你問模型如何制造生化武器或者幫助你制造生化武器。模型看過所有的生物學教科書和所有的研究論文,閱讀并消化他們,通過它們的推理能力從其它領域遷移知識。你不能通過從訓練前移除這些數據來解決這一問題。

更重要的是,就像很多你不想讓模型說的冒犯性的話。有一些可能被認為非常冒犯的短語,如果僅僅逐字逐句地看,其中的詞聽起來是無害的,就好比「童言無忌」。

如果從預訓練中去掉所有這些數據,這個模型就不會意識到它說了一些冒犯性的話。因為,我們想讓模型明白它在說一些冒犯的話,以便訓練它不要那樣做。這似乎是不可避免的,或者看起來我認為不太可能通過移除預訓練數據來解決問題。

在某種程度上,有時你訓練的模型并沒有產生「不對齊」。但也許你用不符合人類偏好的函數訓練它。此時,如果最終模型與你的偏好不相符,這并不奇怪。

Q9:超級對齊的目標是盡量減少日益強大的 AI 系統所帶來的風險并盡量最大化它的好處。但僅僅通過超級對齊不足以實現這一目標。如何看待超級對齊背景下的人工智能治理問題?

Jan:這兩者是不同的問題。它們在某些方面是重疊的。如果你能解決對齊問題,就有能幫你解決其它問題的對齊后的模型。對于開源模型來說,對齊治理問題可能也特別突出。

我們可以做出一個完全對齊的開源模型,人們也可能去掉對齊讓模型做一些不安全的事情。因此,如何管理模型的使用和誤用,包括開源模型,似乎是一個非常開放的問題。