編輯:陳萍、杜偉

研究者希望這篇文章對神經網絡架構感興趣的人有所幫助,特別是那些正在尋找不同角度進行研究的研究者。

深度學習的基本原理可以追溯到幾十年前,20 世紀 80 年代 Geoffrey Hinton 等人提出了基于梯度的反向傳播學習算法,而 Con.NETs 從早期就被應用于手寫數字識別等計算機視覺任務。然而,深度學習的真正威力直到 2012 年才顯露出來,那年 AlexNet 贏得了 ImageNet 大規模圖像分類挑戰賽。

之后數據可用性的提高、計算技術的進步和算法的改進使得深度學習持續取得成功。隨著最近大型模型的興起,這一領域的快速發展還沒有顯示出放緩的跡象。

深度學習不僅對我們的日常生活產生了顯著的影響,還改變了機器學習從業者和研究人員的工作流程。新的設計原則不斷被提出,例如 ResNet 引入殘差連接、 Transformers 采用多頭自注意力等。在算法不斷發展的過程中,效率和可擴展性是兩個不能忽視的概念,讓視覺模型變得既小又大又成為另一需求。

怎樣理解既小又大呢?小模型代表對效率的需求,因為視覺識別系統通常部署在邊緣設備上;大型模型突出對可擴展性的需求,其可以利用日益豐富的計算和數據來實現更高的準確率。最近幾年這兩個方向的研究都取得了卓越成效,產生了許多有用的設計原則被后來的研究所采用。

本文中,來自 UC 伯克利的博士生劉壯(Zhuang Liu)在其博士論文《 Efficient and Scalable Neural Architectures for Visual Recognition 》中,從兩個方面展開研究:(1)開發直觀的算法以實現高效靈活的 ConvNet 模型推理;(2) 研究基線方法以揭示擴展方法成功的原因。

具體而言,首先,本文介紹了關于密集預測的第一個隨時算法研究。然后,該研究將模型剪枝算法與簡單的基線方法進行比較來檢查模型的有效性。最后研究者提出了這樣一個問題,即通過采用 Transformer 中的設計技巧對傳統的 ConvNet 進行現代化改造,來測試純 ConvNet 所能達到的極限,并探索在視覺任務上自注意力機制在 Transformer 中的可擴展性上所起的作用。

論文地址:https://www2.eecs.berkeley.edu/Pubs/TechRpts/2022/EECS-2022-205.pdf

本文除了提出一個新架構外,該研究還從批判的角度對被認為是微不足道或老式基線的方法或模型進行實證研究,發現當提供正確的技術時,它們具有驚人的競爭力。

劉壯(Zhuang Liu)現在是 UC 伯克利 EECS(電氣工程與計算機科學) 的博士生,由 Trevor Darrell 教授指導。此外,他還在 Meta AI Research(原 Facebook AI Research )擔任兼職學生研究員。也曾在康奈爾大學、英特爾實驗室和 Adobe Research 擔任訪問研究員或實習生。他于 2017 年在清華大學姚班獲得學士學位。

劉壯的研究重點是準確和高效的深度學習架構 / 方法,他對開發簡單的方法和研究基線方法特別感興趣。他還是大名鼎鼎 DenseNet 的共同一作,憑借論文《Densely Connected Convolutional Networks》,摘得 CVPR 2017 最佳論文獎。

章節內容簡介

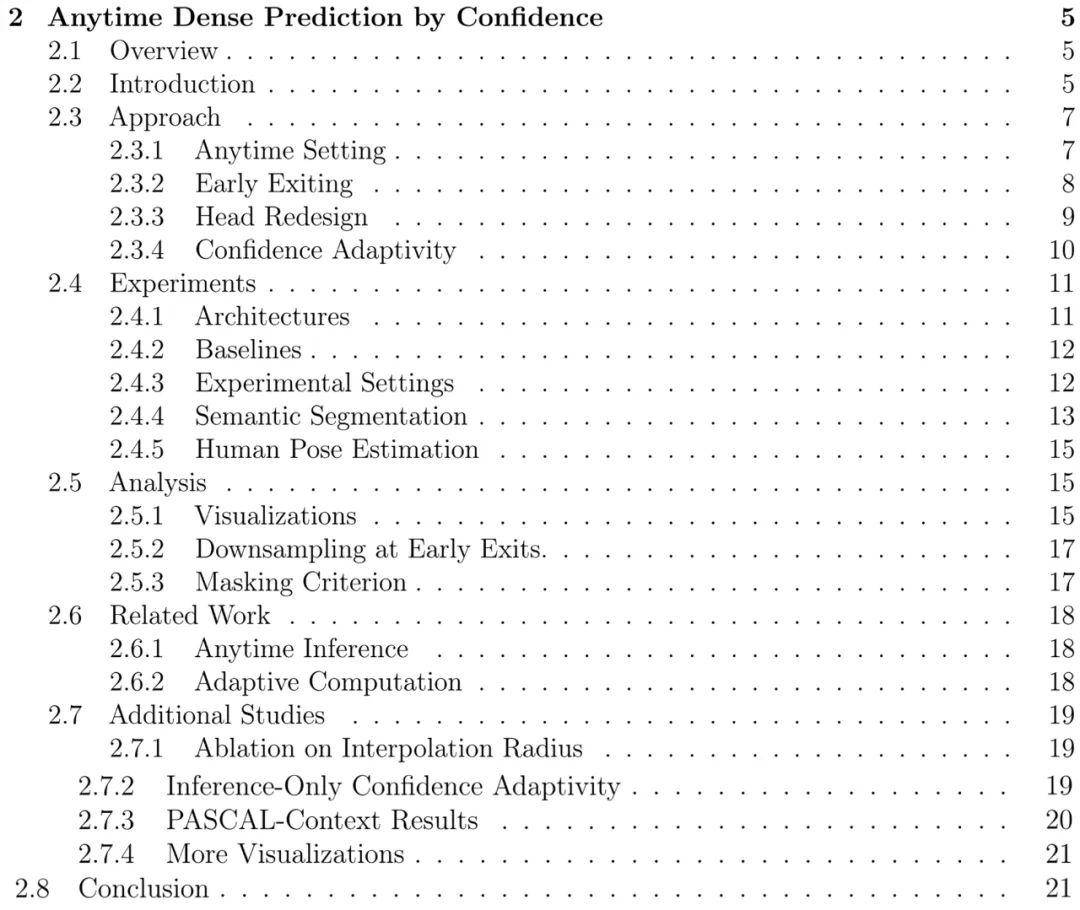

第二章:基于置信的隨時密集預測

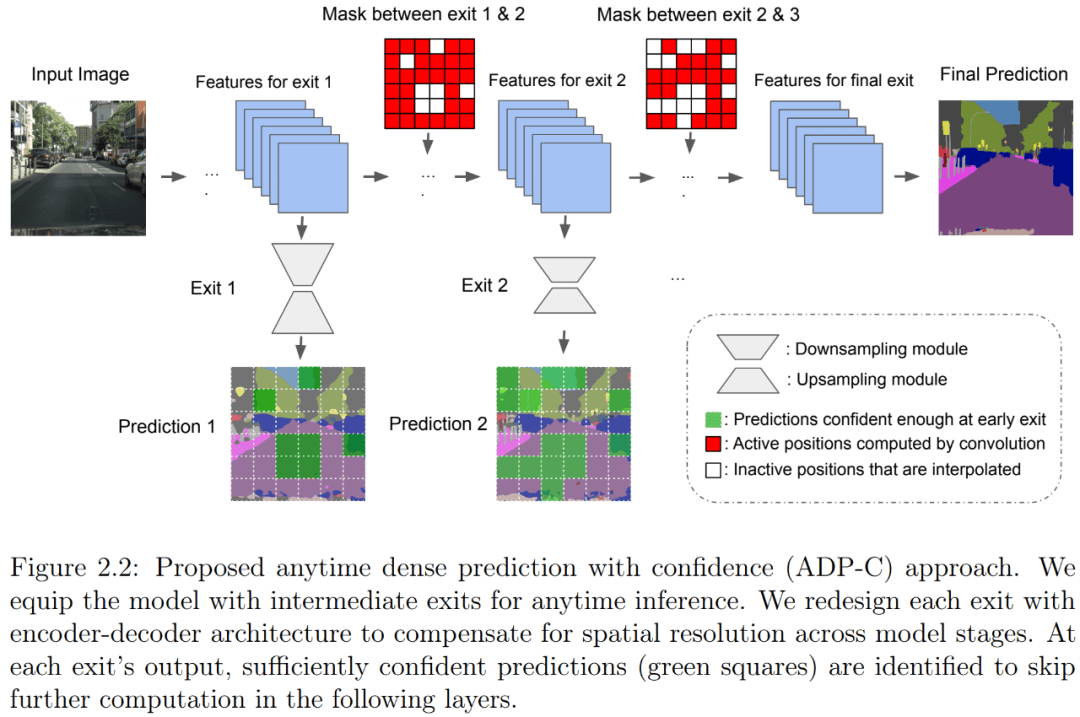

本文介紹了一種隨時密集視覺識別方法,它可以讓神經網絡推理更加靈活。隨時推理需要一個模型對隨時可能的停止進行一系列預測。先前關于隨時視覺識別的研究主要集中在圖像分類領域。作者提出了首個用于隨時密集預測的統一和端到端方法。一連串的 exit 被附加到模型上以進行多個預測。作者重新設計了 exit,以考慮每個 exit 的特征的深度和空間分辨率。

為了減少總計算量并充分利用先前預測,作者開發了一種全新的空間自適應方法,以避免在早期預測已經足夠置信的區域上進行進一步計算。這一方法被命名為基于置信的隨時密集預測(anytime dense prediction with confidence, ADP-C),它達到了與基礎模型相同的最終準確率水平,同時顯著減少了總計算量。

ADP-C 方法概覽。

作者在 Cityscapes 語義分割和 MPII 人體姿態估計數據集上評估了所提方法,結果表明,ADP-C 可以在不犧牲準確率的情況下隨時進行推理,同時還將基礎模型的總 FLOPs 減少 44.4% 和 59.1%。作者還與基于深度平衡網絡和基于特征的隨機采樣進行的隨時推理進行比較,表明 ADP-C 在準確率 - 計算曲線上始終占有優勢。

本章目錄如下:

第三章:重新思考網絡剪枝的價值

與上章中的自適應計算隨時推理方法相比,靜態神經網絡剪枝方法試圖通過與輸入無關的方式減少神經網絡的計算量。由于自身具有的簡單性、有效性以及有時更好的硬件兼容性,這類方法通常在實踐中用于縮小模型。在本章中,作者試圖了解靜態神經網絡剪枝方法成功背后的底層機制。

典型的剪枝算法是一個三段式的 pipeline,分別為訓練(大模型)、剪枝和微調。在剪枝過程中,根據一定的標準對冗余權重進行剪枝,并保留重要的權重,以保持最佳準確率。在這項工作中,作者提出了一些與常見看法相悖的觀察結果。對于其檢查過的所有 SOTA 結構化修剪算法,對修剪后的模型進行微調只能得到與使用隨機初始化權重訓練模型相當或更差的性能。對于假設預定義目標網絡架構的剪枝算法,則可以擺脫整個 pipeline 并直接從頭開始訓練目標網絡。

作者的觀察結果對于多個網絡架構、數據集和任務是一致的,這意味著:1)通常不需要訓練大型、過度參數化的模型來獲得高效的最終模型;2)學得的大模型的「重要」權重通常對小型剪枝模型沒有用處;3)對最終模型的效率更關鍵的是剪枝后的架構本身,而非一組繼承的「重要」權重。這表明在某些情況下,剪枝可能作為架構搜索范式產生作用。

結果表明,未來結構化剪枝方法的研究中需要進行更仔細的基線評估。作者還與「彩票假設」(Lottery Ticket Hypothesis)進行了比較,發現在最佳學習率下,彩票假設中使用的「中獎彩票」初始化并沒有帶來隨機初始化的改進。

本章目錄如下:

第四章:A ConvNet for the 2020s

剪枝是一種流行的縮小模型的方法。在上章中,作者通過實證研究證明了結構化剪枝的真正價值不是獲得一組特定的權重值,而是識別出一個有用的子架構。在本章中,作者將注意力轉向擴展計算機視覺神經架構。

一個經典的例子是 ResNets,它提出了殘差連接。將沒有殘差連接的「普通」網絡擴展到數十層會導致訓練損失增加,更不用說測試準確率變差了。然而,一個具有殘差連接的 ResNet 可以擴展到 100 多層,同時改進了訓練損失和測試準確率。之后,Vision Transformers 開始顯現出比基于卷積的 ResNet 更大的可擴展性。作者試圖通過與現代化 ConvNet 的比較,來了解 Transformers 擴展成功的背后是什么。

作者重新檢查了設計空間并測試了純 ConvNet 所能達到的極限,并逐漸將標準 ResNet「升級(modernize」為視覺 Transformer 的設計,在過程中發現了導致性能差異的幾個關鍵組件。作者將一系列純 ConvNet 模型命名為 ConvNeXt。ConvNeXt 完全由標準 ConvNet 模塊構建,并且在準確率和可擴展性方面,ConvNeXt 取得了媲美 Transformer 的結果,達到 87.8% ImageNet top-1 準確率,在 COCO 檢測和 ADE20K 分割方面優于 Swin Transformer,同時保持標準 ConvNet 的簡單性和有效性。

本章目錄如下:

更多詳細內容請參閱原論文。