近日,美國人工智能芯片初創企業Groq宣布成功從沙特阿拉伯獲得高達15億美元的融資,這筆資金將用于擴展其位于沙特的人工智能基礎設施。

據悉,Groq已在沙特阿拉伯達曼設立了中東地區最大的推理集群,該集群包含19000個Groq LPU(語言處理單元),并于2024年12月迅速上線運行。這一舉措展現了Groq在人工智能領域的雄心壯志。

在沙特阿拉伯利雅得舉行的LEAP 2025活動上,Groq的首席執行官兼創始人喬納森·羅斯宣布了這一融資消息。他表示,這筆資金將主要用于提高LPU的產量,同時也有可能用于將設計迭代到更先進的制造工藝節點,以及開發更多樣化的AI處理器。

Groq自2016年成立以來,便以其獨特的技術和強大的團隊實力在AI芯片領域嶄露頭角。其核心團隊源自谷歌最初的張量處理單元(TPU)工程團隊,擁有豐富的研發經驗和技術積累。創始人兼CEO喬納森·羅斯更是谷歌TPU項目的核心研發人員之一。

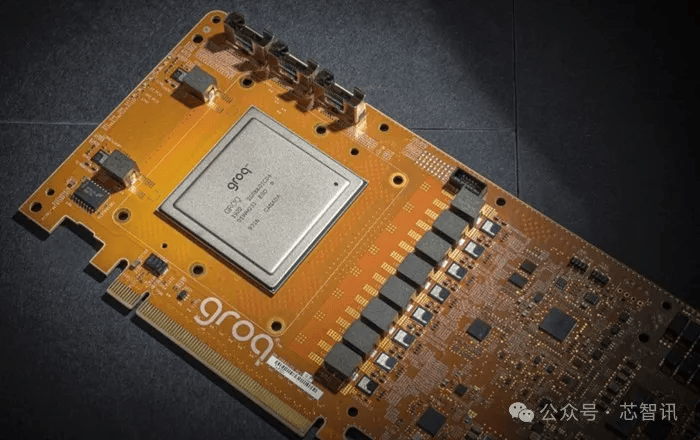

2024年2月,Groq推出了全球首個基于LPU方案的大模型推理芯片——Tensor Streaming Processor (TSP)。這款芯片采用全新的TSA架構,旨在提高機器學習和人工智能等計算密集型工作負載的性能。盡管它并未采用高昂的尖端制程工藝,而是選擇了14nm制程,但憑借自研的TSA架構和高度并行處理能力,Groq LPU芯片仍然展現出了卓越的性能。

據官方數據顯示,Groq的LPU芯片可提供高達1000 TOPS(每秒萬億次運算)的計算能力,并且在某些機器學習模型上的性能表現比常規的GPU和TPU提升10到100倍。該芯片還集成了230MB容量的SRAM來替代DRAM,以保證內存帶寬,其片上內存帶寬高達80TB/s。

在實際應用中,基于Groq LPU芯片的云服務器在Llama2或Mistreal模型上的計算和響應速度遠超基于NVIDIA AI GPU的ChatGPT。據Groq表示,其LPU芯片每秒可以生成高達500個token,而ChatGPT-3.5的公開版本每秒只能生成大約40個token。這意味著Groq LPU芯片的響應速度達到了NVIDIA GPU的10倍以上。與其他云平臺廠商相比,基于Groq LPU芯片的云服務器的大模型推理性能也實現了顯著提升。

在能耗方面,Groq LPU芯片同樣表現出色。英偉達GPU需要大約10到30焦耳才能生成響應中的tokens,而Groq LPU芯片僅需1到3焦耳。這意味著在推理速度大幅提升的同時,其能耗成本僅有英偉達GPU的十分之一,性價比提高了100倍。

Groq的策略是使用光纖互連將數百個LPU拼接在一起,每個LPU都裝有片上SRAM。通過使用576個LPU的集群,Groq聲稱能夠在meta的Llama 2 70B模型上實現每秒超過300個令牌的生成速率,是具有8個GPU的HGX H100系統的10倍,同時消耗十分之一的功率。

在演示中,Groq展示了其芯片的強大性能,支持多種模型,如Mistral AI的Mixtral8x7B SMoE以及meta的Llama2的7B和70B等。這些模型支持使用4096字節的上下文長度,并可直接體驗Demo。Groq還表示,其LPU推理芯片在第三方網站上的售價低于NVIDIA H100,進一步彰顯了其性價比優勢。

值得注意的是,盡管Groq的LPU芯片性能卓越,但它同樣受到了美國出口管制政策的影響。不過,據路透社報道,Groq已獲得必要的許可證以向沙特阿拉伯出口其產品。