DeepSeek公司近期宣布,其備受矚目的“開源周”活動已正式啟動,首個對外開放的代碼庫被命名為FlashMLA。據內部消息透露,此次活動期間,DeepSeek計劃總計開源五個重要的代碼庫。

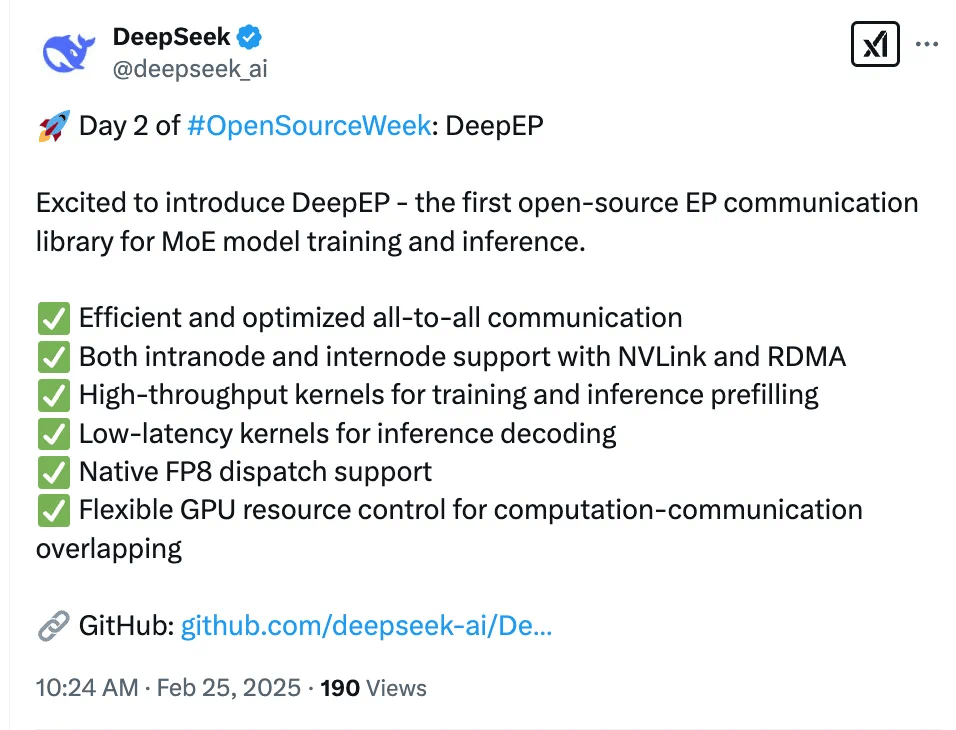

緊接著首個開源項目的發布,DeepSeek再度傳來喜訊,正式推出了第二個開源項目——專為MoE模型(混合專家模型)的訓練與推理設計的EP通信庫DeepEP。這一舉措標志著DeepSeek在推動人工智能領域開源生態發展的道路上邁出了堅實的一步。

DeepEP通信庫以其卓越的性能和多功能性脫穎而出,它具備以下幾大亮點:

首先,DeepEP實現了高效優化的All-to-All通信機制,這一特性顯著提升了模型在分布式訓練環境下的數據傳輸效率。其次,該庫全面支持NVLink和RDMA技術,無論是節點內部還是跨節點的通信,都能實現低延遲、高帶寬的數據傳輸。DeepEP在訓練和推理的預填充階段,提供了高吞吐量的計算核心,確保了模型處理的快速響應。

在推理解碼階段,DeepEP則采用了低延遲的計算核心,進一步優化了模型在實際應用中的表現。該庫原生支持FP8數據分發,這一特性使得模型在處理高精度數據時能夠更加高效。同時,DeepEP還提供了靈活的GPU資源管理功能,使得計算與通信任務能夠高效重疊,進一步提升了整體性能。

DeepSeek此次開源的DeepEP通信庫,無疑為人工智能領域的研究者和開發者提供了一個強大的工具,不僅有助于推動MoE模型的發展,也為整個行業的創新注入了新的活力。