在科技行業的浩瀚星空中,一系列閃耀的上市公司構成了數字經濟的璀璨星河,其中包括阿里巴巴(09988.HK,BABA.US)、百度(09888.HK,BIDU.US)、騰訊(00700.HK, TCEHY)等科技巨頭,以及科大訊飛(002230.SZ)、萬興科技(300624.SZ)、三六零(601360.SH)、昆侖萬維(300418.SZ)、云從科技(688327.SH)、拓爾思(300229.SZ)等各具特色的創新企業。

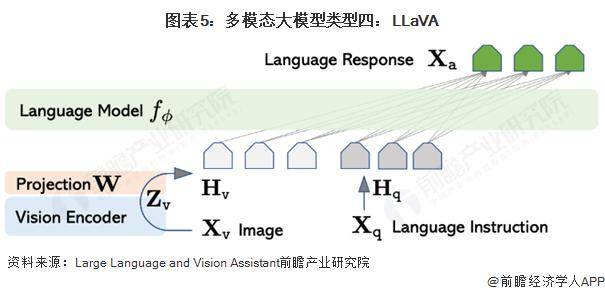

近年來,多模態大模型技術成為人工智能領域的熱門話題。這類模型通過融合視覺與語言等多種信息模態,實現了更深層次的智能交互。主流方法之一是借助預訓練好的大語言模型和圖像編碼器,通過圖文特征對齊模塊,讓語言模型能夠“看懂”圖像,進而進行復雜的問答推理。這種方法不僅減少了對高質量圖文對數據的依賴,還通過特征對齊和指令微調等技術,實現了不同模態間的無縫銜接。

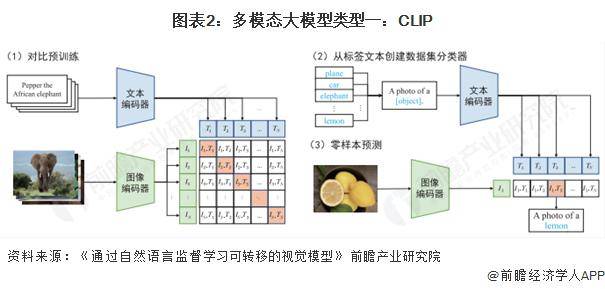

在多模態大模型的探索中,CLIP模型以其獨特的對比學習方法脫穎而出。CLIP由OpenAI提出,通過文本信息訓練視覺模型,實現了zero-shot分類能力。它利用預訓練好的網絡,通過計算文本標簽與圖片的余弦相似度,預測圖片的分類結果。CLIP的創新之處在于,它利用句子模板作為提示信息,提高了分類效果,這一方法被稱為prompt engineering。

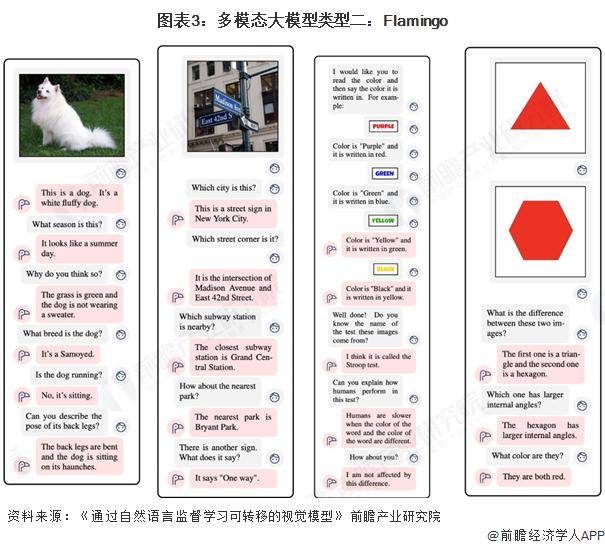

Flamingo模型則是另一款備受矚目的多模態大型語言模型。它不僅具備CLIP的圖像和文本對齊能力,還能根據視覺和文本輸入生成文本響應。Flamingo通過視覺編碼器將圖像轉換為嵌入,再與語言模型結合,實現了跨模態的智能交互。其訓練數據集包括圖像-文本對、視頻-文本對以及交錯的圖像和文本數據集,為模型的泛化能力提供了堅實基礎。

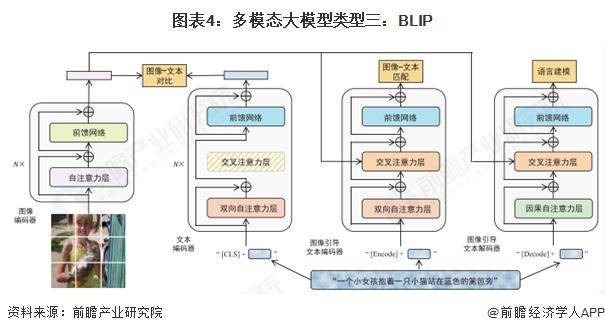

Salesforce提出的BLIP模型,在多模態預訓練領域同樣占有一席之地。BLIP旨在統一視覺語言任務的理解與生成能力,并通過處理噪聲數據來提高模型性能。與CLIP相比,BLIP不僅關注圖像和文本的對齊問題,還致力于解決圖像生成、視覺問答和圖像描述等復雜任務。其采用的引導學習方式,通過自監督手段增強了模型對語言和視覺信息的理解能力。

利用視覺編碼器CLIP ViT-L/14與語言解碼器LLaMA結合,構建多模態大模型,并通過指令微調提升性能,也是當前研究的一大熱點。這種方法通過將視覺Token與語言Token置于同一特征空間,實現了跨模態的信息融合與交互,為人工智能的未來發展開辟了新的道路。