杭州靈汐類腦科技有限公司攜手中國電信、中國電子科技南湖研究院及腦啟社區,于七月底成功啟動了“杭州靈汐類腦智算集群”的企業服務試運行,標志著大模型快速推理API正式步入商業化測試階段。該集群由杭州電信負責集成建設,落戶于中國電信杭州智算中心,算力規模突破200POPS大關,成為全球首個以支持大模型快速推理方式投入商用的類腦智算集群。

作為類腦智能技術的創新實踐,“杭州靈汐類腦智算集群”憑借其獨特的“存算一體、眾核并行、稀疏計算、事件驅動”特性,在計算效率與能耗控制上實現了質的飛躍。這一技術革新不僅大幅提升了大語言模型的推理速度,將單用戶推理延遲縮短至毫秒級,相較于傳統方案,其速度性能優勢顯著,能夠流暢應對實時交互與深度推理需求,徹底告別卡頓現象。同時,首token延遲也顯著降低,達到百毫秒乃至十毫秒級別。該智算集群的功耗較業界同等推理算力水平降低了二分之一至三分之二以上,展現了極高的能效比。

圖:靈汐智算平臺大模型登錄界面

異構融合類腦芯片是該集群的另一大亮點,其內置的類CUDA軟件棧兼容PyTorch框架,使得多類開源大模型無需轉換類腦算法即可直接享受快速推理服務。這一特性極大地拓寬了類腦智算集群的應用范圍,為行業提供了更為便捷、高效的解決方案。

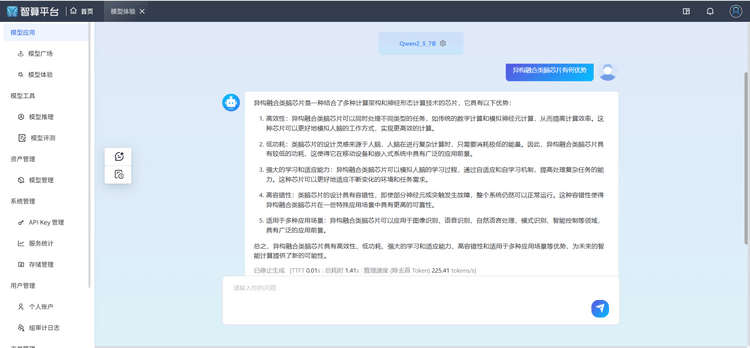

圖:靈汐智算平臺大模型快速推理界面

當前,大模型推理領域普遍面臨吞吐速度慢、高延遲等挑戰,這對眾多行業應用場景構成了嚴重制約。針對這一問題,靈汐科技憑借類腦智能技術,推出了“高實時、高吞吐、低延遲”的推理服務解決方案。該方案在金融應用、情感陪聊、快速導覽、大規模數據標注以及無人機實時航拍處理、災害預警與應急處置等多個領域展現出巨大潛力,有望推動這些行業向更高效、更智能的方向發展。