version 8.14

摘要:為破解大模型部署與推理成本高昂的困境,北京大學楊仝老師團隊首次提出名為iFairy的超低比特量化方案。該方案創新性地利用復數{±1, ±i}對模型權重進行2-bit量化,在實現1/8極致壓縮與“無乘法”推理加速的同時,語言建模能力和下游任務表現甚至反超了其全精度的LLaMA基座模型。

當下,大語言模型(LLM)的研究熱潮席卷全球,技術迭代日新月異。然而,在這片繁榮之下,一個嚴峻的現實不容忽視:LLM在真實世界中產生的商業價值,很大程度上仍無法覆蓋其高昂的訓練與推理成本。

究其根源,大模型走向產業落地的道路上,橫亙著兩大“攔路虎”:空間瓶頸和時間瓶頸。

為了追求更高的模型性能,業界普遍的策略是不斷堆疊參數量,這使得模型部署成本高昂。

同時,龐大的參數量帶來了計算量的激增,盡管學界和業界已涌現出如gpt-oss的MXFP4訓練等優秀的量化方案,但其核心計算邏輯依然沒有消除對硬件資源消耗巨大的“乘法”運算的依賴,推理延遲沒有實現根本性的降低。

能否同時攻克這兩大瓶頸,實現模型的輕量化和推理加速,已成為推動大模型發展從“技術奇觀”邁向“生產力工具”新階段的關鍵。

為解決這一難題,北京大學楊仝老師團隊在一篇名為“iFairy: the First 2-bit Complex LLM with All Parameters in {±1,±i}”的論文中,提出了一個腦洞大開的方案:跳出實數軸的束縛,進入復數平面!

這看似簡單的維度提升,卻蘊含著破解瓶頸的深刻智慧。

一、空間魔法:極致壓縮,體積僅為1/8

在“空間”上,iFairy實現了極致的壓縮。

傳統的全精度(FP16)權重需要16比特,而iFairy方案僅用2比特,就完成了對一個權重信息的編碼。

這意味著,相較于流行的FP16模型,其模型體積可以直接壓縮至原來的1/8。這種“史詩級”的壓縮率,為大模型在手機、汽車等邊緣設備上的部署掃清了最大的存儲障礙。

二、時間魔法:“無乘法”計算的革命

在“時間”上,iFairy實現了“無乘法”計算的革命。這個魔法是如何實現的呢?

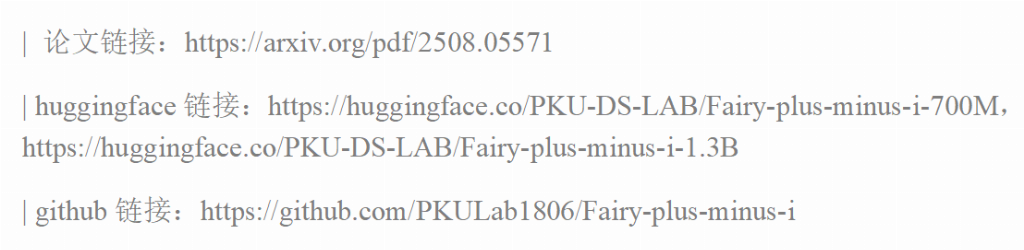

1. PhaseQuant算法的神來之筆

這一切,都源于團隊提出的全新量化算法PhaseQuant。它不再將權重映射到實數軸上的點,而是基于參數的相位將其映射到復平面上的四個單位根{±1, ±i}。

這一操作堪稱神來之筆,一舉多得:

信息密度拉滿:用{±1, ±i} 四個值,徹底利用了2-bit的全部信息容量,信息熵從傳統三元量化(如BitNet b1.58)的log?(3)≈1.58-bit,提升到滿格的log?(4)=2-bit。

優雅的對稱性:這四個點在復平面上關于原點中心對稱,保持了模型訓練所需的良好性質。

隱含的稀疏性:每個量化后的復數權重,其實部或虛部必有一個為零,這在高維度上保留了稀疏性的優勢。

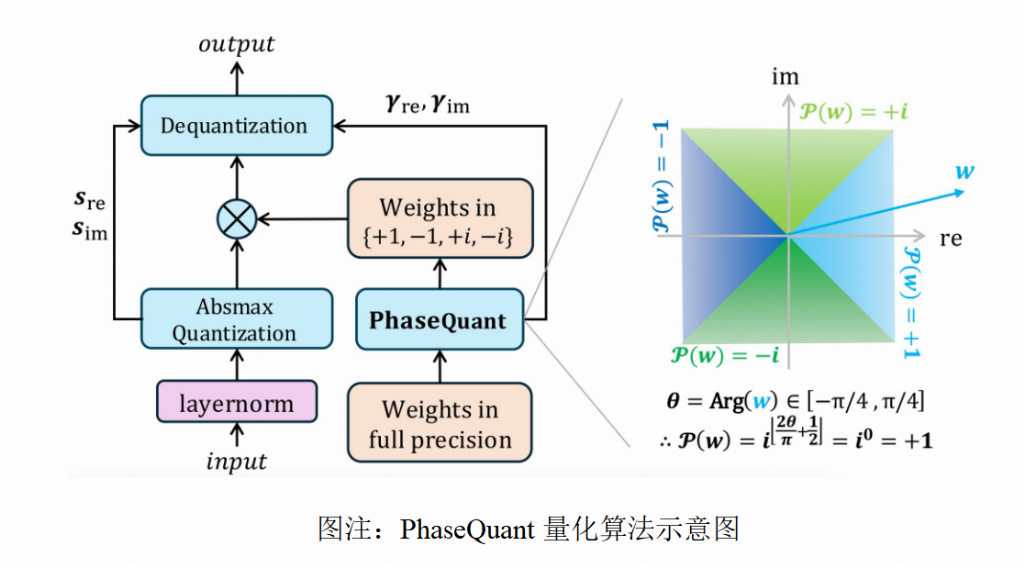

2. 驚艷的“無乘法”運算

最令人拍案叫絕的是,引入復數,計算仍然高效!一個標準的復數乘法 (a+ib)(c+id) 需要4次實數乘法和2次加法,計算量不小。

但在iFairy模型中,當一個復數激活值與量化后的權重 {±1, ±i} 相乘時,運算發生了奇妙的“退化”:所有乘法都消失了。

看!整個模型中最核心、最龐大的矩陣乘法(GEMM),被徹底重構了!原本昂貴的浮點乘法運算,被完全替換為硬件成本幾乎為零的加法、減法和數據交換(shuffle)操作。這從根本上消除了計算瓶頸,為實現數量級的推理加速提供了可能。

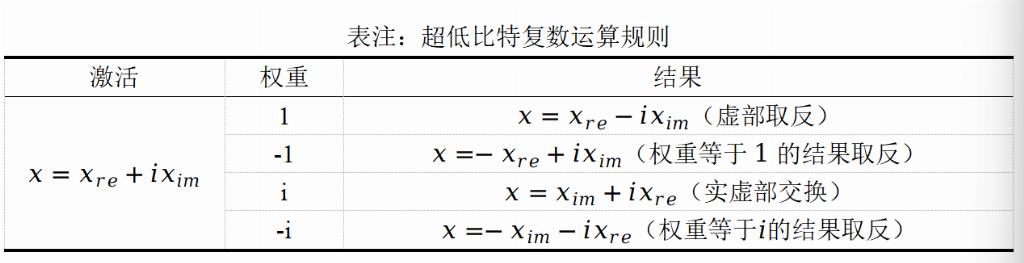

三、架構革新:一個全面“復數化”的Transformer

為了讓這個魔法完美落地,研究團隊還將整個Transformer架構都進行了“復數化”改造。

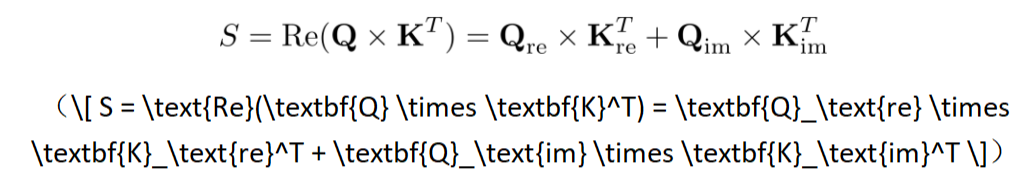

復數注意力機制:傳統注意力計算Q和K的點積,這里則巧妙地使用了Hermitian內積的實部作為相似度分數,既利用了所有復數信息,又自然地得到了實數分數用于Softmax。

復數旋轉位置編碼(RoPE):在復數域,位置編碼的旋轉操作變得異常簡潔和統一,一個簡單的復數乘法即可實現。

四、驚艷成果:PPL降低10%,性能反超全精度!

理論如此優雅,實踐效果如何呢?結果同樣令人矚目。

iFairy 不僅沒有出現超低比特量化常見的性能懸崖,反而實現了驚人的性能反超。

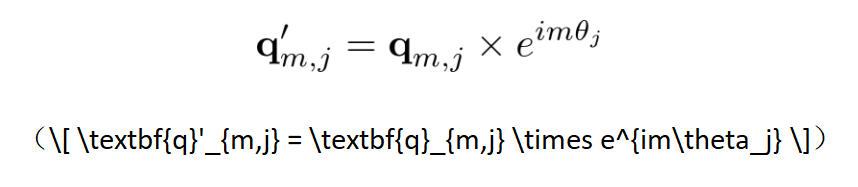

在LLM的語言建模能力方面,模型的困惑度(PPL)越低,代表模型對文本的理解和預測能力越強。在對PPL的測試中,基于相同數據集訓練(注:為保證對比的嚴謹性,所有對比模型的訓練數據均保持一致,具體信息可參見論文)的2-bit的iFairy 模型取得了比全精度(FP16)模型更低的困惑度(PPL),降幅高達 10%。

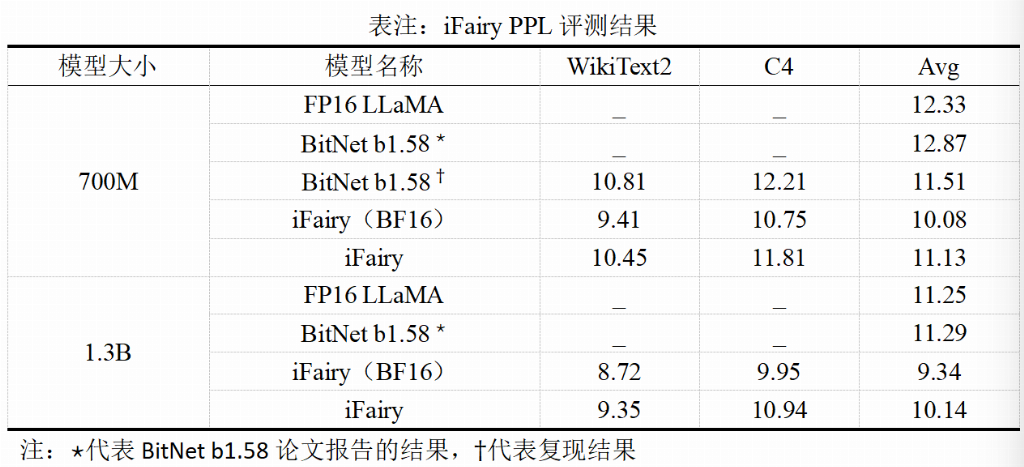

而在下游任務評測方面,iFairy 模型更是在多個任務的評分反超了全精度的Llama基座模型。

這意味著,一個體積只有原來1/8、計算幾乎“零”乘法的模型,其能力反而更強了。這徹底顛覆了我們的傳統認知。

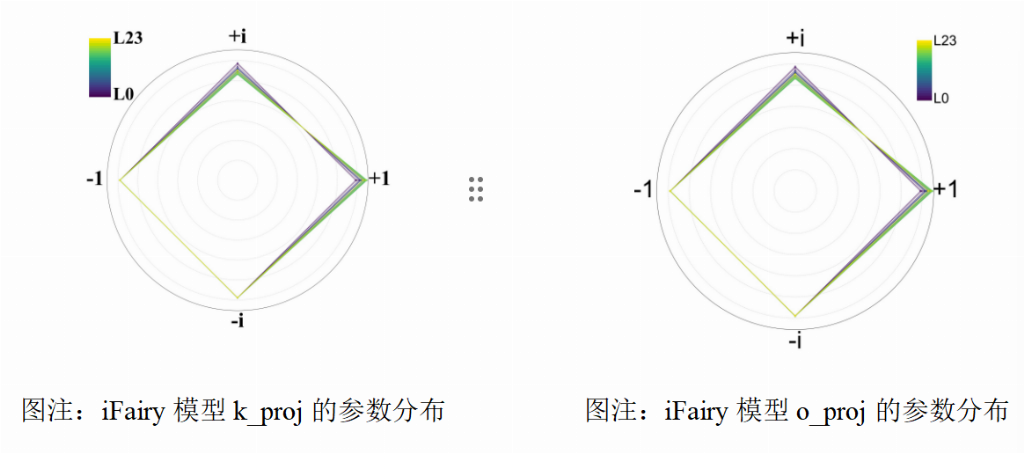

對量化后權重的分析還發現,模型在訓練后,這四個復數值 {±1, ±i} 的分布非常均勻,證明模型確實學會了充分利用這套全新的“編碼系統”。

總而言之,這項工作開創性地將復數神經網絡的思想與超低比特量化相結合,通過利用“相位”這一被忽略的信息維度,在不增加任何存儲成本的前提下,顯著提升了模型的表達能力和最終性能,真正實現了“魚與熊掌兼得”。

它為設計下一代超高效、高性能的大語言模型,打開了一扇全新的大門。或許,我們離在普通手機上流暢運行GPT-5級別的模型,又近了一步。 相關論文、訓練代碼、模型權重與實驗腳本已全部開源,配套提供從訓練、評測到可復現實驗的完整流程,人人皆可復現訓練。