“模型推理是最直接跟AI應用相關的環節,更多的數據、更大的模型以及更長的上下文窗口能夠帶來更高效的人工智能。但是有個問題,更高的智能要求的推理負載極重,模型參數以及推理過程中產生的KV Cache都需要很大的存儲空間。”

------清華大學教授、中國工程院院士 鄭緯民

如鄭緯民院士所說,模型推理是最直接跟AI應用相關的環節,也是連接模型訓練和應用落地的橋梁。當前,大模型推理仍需要借助GPU算力來實現,在大模型推理過程中會產生大量的KV Cache并存到GPU服務器的HBM顯存中。對于連續長文本對話而言,拋棄已有的KV Cache無疑會讓GPU服務器陷入“重復計算”的陷阱,延長回復時間,降低用戶體驗,而要存儲全部的KV Cache則需要更多的GPU服務器,這無疑會極大拉高AI infra的建設成本。在這種情況下,如何存儲推理過程中產生的KV Cache,避免重復計算,在保證響應速度的同時降低大模型推理的成本,是當前大模型應用落地所面臨的最關鍵的問題。

如果把大模型推理比作連環漫畫創作,場景是這樣的:

長篇漫畫作者小劉有個習慣:創作新話時,總會先回顧前話的全部內容,再參考過往情節脈絡逐話推進劇情。每一話完結后,他會把核心情節寫在便利貼上(K/V),貼在工作室的“漫畫故事墻”(KV Cache)上。后續創作時,他只需掃一眼墻上的便利貼,就能快速銜接前情,不用再翻舊稿。

可讀者催更太頻繁,開的連載越來越多,一話接一話的內容堆下來,“漫畫故事墻” 漸漸貼滿了,再也塞不下新的便利貼。沒辦法,他只能回頭翻完整的漫畫書,一點點回顧前情。擴大“漫畫故事墻”固然可以,但是工作室砸墻擴墻的成本實在太高了。最近編輯催得越來越緊,小劉急得直轉圈:怎樣才能在截稿日前提高效率,按時交稿呢?

專業漫畫家小李(Inspur Data)給出了以下幾點方案:

其一,超大檔案柜隨時補。小李為小劉提供了一個“劇情檔案柜”,并給它起了一個響當當的名字——AS3000G7!“漫畫故事墻”放不下的便利貼就放到劇情檔案柜,小劉回顧漫畫內容時,即便“漫畫故事墻”沒有,檔案柜也能夠及時補上,給“漫畫故事墻”擴了容。

其二,小張調度有一套。有了“檔案柜”還不夠,還得讓小劉能快速取用便利貼才行!為加快取用速度,小李為小劉配備了畫稿調度員小張(IO管理容器)。小張是個能人,小劉對劇情便利貼的需求大時,他派多個助理同時去檔案柜取(智能多路徑優化),“漫畫故事墻”便利貼快空時,他立刻安排檔案柜補全,還趁小劉更新漫畫間隙,提前把熱門漫畫的歷史內容搬過來(動態緩存管理)。無論歷史內容便利貼存放還是取用,小張都能安排得順暢高效。

其三,老趙管理有高招。為了提高檔案柜的使用效率,小李推薦了檔案管理員老趙(Turbo KV加速引擎),老趙更有訣竅。他把歷史劇情便利貼定向規整存放(KV Cache定向壓縮),同樣的空間能多存一半。他還把那些放了半年沒有翻過的歷史劇情稿及時清理(容量管理加速),讓檔案柜空間得到充分利用。

接下來,我們將一一介紹這三個推理效率提升手段背后的實現原理及主要價值。

01外置存儲:用“劇情檔案柜”突破容量極限

大模型在推理過程中會產生大量的KV Cache,如DeepSeek-70B每10分鐘就會產生25TB的KV Cache,這些KV Cache需要存儲到GPU服務器的HBM顯存里,以加快連續長文本對話的反響應速度。而在當前主流的GPU服務器中,HBM顯存容量普遍不超過128GB,相對動輒幾十、上百TB的KV Cache來說,顯然有些不夠看了。

為了處理這類問題,外置存儲成為學研用界都在考慮的方案。基于此,浪潮存儲推出專為提升大模型推理效率的推理加速存儲----AS3000G7。

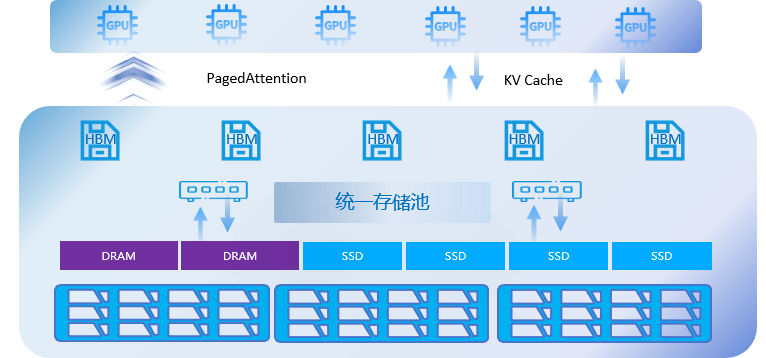

在硬件上,AS3000G7采用硬件池化技術,對HBM顯存、DRAM、SSD存儲資源進行統一整合,虛擬為統一資源池。同時采用Pagedattention技術來對接大模型,對KV緩存進行“分塊-局部計算-跨頁關聯”,將長序列分割成固定大小的Block,并通過虛擬頁分配技術實現非連續內存分配,進一步提升存儲資源池的利用率。通過AS3000G7,可以將HBM的空間“擴展”300多倍,減少GPU重復計算帶來的資源消耗,TTFT降低90%。

02 智能調度:讓“畫稿調度員”盤活供需鏈路

僅用外置存儲來存儲KV Cache并無法完全實現連續長文本對話的快速響應,原因顯而易見:DRAM和SSD的讀寫速度與HBM存在近百倍的差距(HBM:1-3TB/s,DRAM:40-50GB/s,SSD:10-15GB/s)。因此,加快外置存儲和HBM之間的通信是保證外置存儲方案落地的關鍵點。

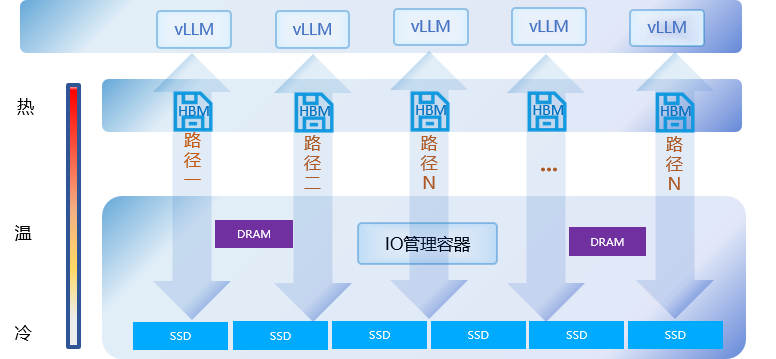

針對這個問題,AS3000G7提出了IO管理容器的方案。在應用過程中,AS3000G7和大模型結合進行智能多路徑優化,為每個LLM層分配獨立NVMe隊列,實現多GPU張量并行下的many-to-many連接,針對LLM高頻、隨機、小IO特征(10KB-160KB),動態優化數據傳輸路徑。同時,AS3000G7基于動態緩存管理技術對vLLM調度器算法進行了優化,實時監控Block使用頻率,將高頻Block保留在HBM,低頻Block下沉至AS3000G7,KV Cache可以基于使用頻率在不同的介質中自由流動。通過動態緩存管理和智能多路徑優化,AS3000G7支持的GPU服務器吞吐量(Token/s)可達原方案5倍,單位GPU資源可承載更多推理請求。

03 精細管理:靠“檔案管理員”提升經營效率

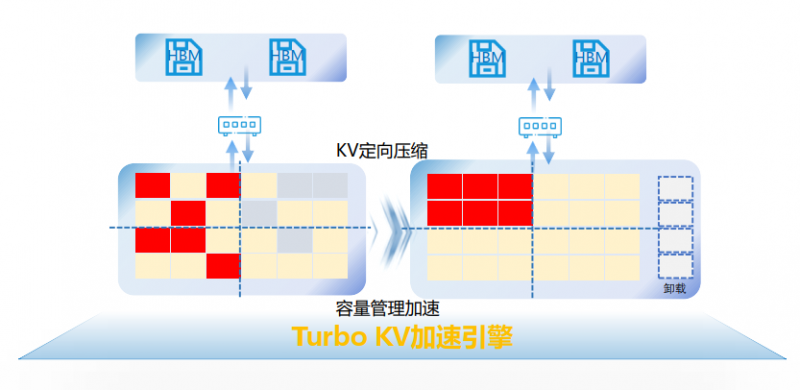

對于大模型的存儲集群而言,充分利用存儲空間同樣有助于降低大模型推理成本。AS3000G7采用KV Cache定向壓縮技術,針對LLM重復KV進行優化,降低SSD寫放大,提升空間利用率。同時,AS3000G7采用容量管理加速算法,基于TTL/LRU策略對無效KV Cache進行卸載,并通過自定義的Block Container元數據結構,精準追蹤跨層(KV緩存層、HBM層、SSD層)的關聯KV塊,實現“卸載一個對話路徑=凈化整個計算鏈路”。與原方案相比,AS3000G7存儲KV Cache數量可增加50%

小劉聽了專業漫畫家小李的建議,立刻照著方案動了起來。有了 AS3000G7 “劇情檔案柜”當 “大儲備”,小張調度劇情便利貼又快又準,老趙把檔案柜打理得井井有條,小劉創作時,不管是從 “漫畫故事墻” 直接取用還是從“劇情檔案柜”調取前情,速度都比以前快了大半。多話連載銜接時,劇情隨用隨取,卡殼的時間少了,哪怕同時推進好幾部連載也能穩穩應對。更重要的是,不用再花冤枉錢砸墻擴 “漫畫故事墻”,成本降了,效率卻提了上來 —— 曾經讓小劉頭疼的截稿壓力,這下全解決了!